Compartir:

El desarrollo de agentes inteligentes capaces de entender con precisión las consultas de los usuarios y responder a ellas de manera efectiva es un desafío que implica una planificación cuidadosa y ejecución en varias etapas. Ya sea que se trate de un chatbot para servicio al cliente o un asistente virtual, es crucial considerar múltiples aspectos, desde definir el alcance y capacidades del agente hasta diseñar una infraestructura robusta y escalable.

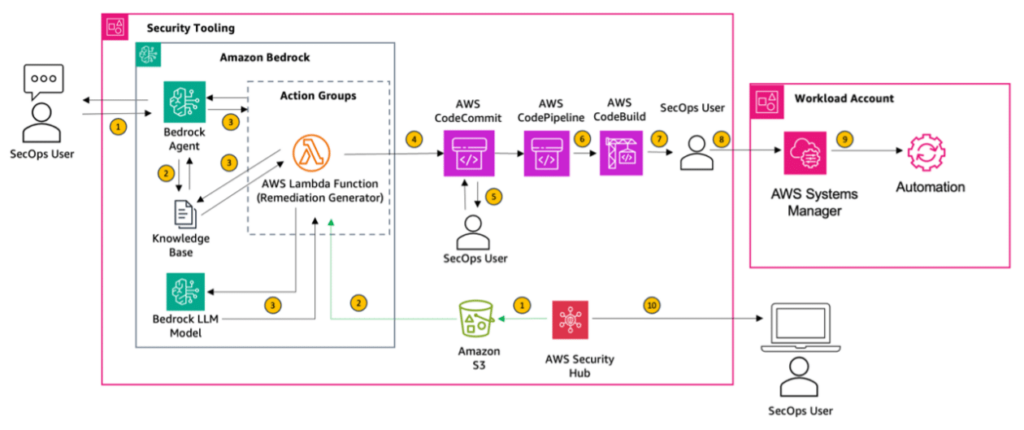

Un nuevo enfoque, dividido en dos partes, está emergiendo como una guía para las mejores prácticas en la creación de aplicaciones de inteligencia artificial generativa mediante el uso de Amazon Bedrock Agents. Estos agentes simplifican el desarrollo al orquestar diversas tareas, utilizando el razonamiento de los modelos base para dividir las solicitudes del usuario en tareas manejables. Con instrucciones de los desarrolladores, se elabora un plan de orquestación que se ejecuta usando APIs y acceso a bases de conocimiento para proporcionar respuestas relevantes a los usuarios.

El primer segmento de este enfoque está dedicado a la construcción de agentes precisos y confiables, mientras que el segundo se enfoca en los aspectos arquitectónicos y las prácticas de desarrollo. Un componente fundamental es la recolección de datos precisos del mundo real, utilizados para evaluar el rendimiento del sistema. Antes de comenzar a construir cualquier aplicación de agente, es crucial recopilar interacciones que impulsarán su ciclo de vida completo.

Definir el alcance del agente, las tareas que debe manejar y sus limitaciones es otro paso esencial. Esto incluye la identificación de funciones principales, formatos de entrada y salida esperados, y establecer expectativas claras que guiarán el proceso de desarrollo.

Desde una perspectiva arquitectónica, es más eficiente construir agentes pequeños y enfocados que interactúan entre sí, en lugar de uno solo, grande y monolítico. Este enfoque mejora la modularidad, mantenibilidad, prueba y depuración, permitiendo también el uso de diferentes modelos de IA para tareas específicas, lo cual mejora la escalabilidad.

Además, planificar la experiencia del usuario de manera cuidadosa, ajustando el tono y presentación del agente, garantiza una interacción consistente y atractiva que se alinea con la identidad de la marca.

La comunicación clara es esencial para la efectividad de estos agentes. Usar lenguaje directo y proporcionar ejemplos específicos para conceptos complejos asegura que las interacciones con las bases de conocimiento se definan sin ambigüedades.

Integrar los agentes con las bases de conocimiento existentes, como Amazon Bedrock Knowledge Bases, puede mejorar significativamente la precisión y relevancia de las respuestas, ofreciendo citaciones de fuentes autorizadas y reduciendo la necesidad de actualizaciones frecuentes del modelo.

Para evaluar la efectividad de un agente de IA, se deben definir criterios específicos de evaluación como la precisión de respuesta, la tasa de cumplimiento de tareas y la coherencia en las conversaciones. Además, la evaluación humana proporciona retroalimentación valiosa en aspectos difíciles de medir automáticamente.

Finalmente, la mejora continua es vital. Probar extensamente, recoger retroalimentación y refinar el rendimiento del agente son pasos críticos para el desarrollo de agentes de IA efectivos y orientados al usuario. La planificación para pruebas A/B y la implementación de grupos de prueba durante el despliegue contribuyen a este proceso iterativo. En conclusión, adherirse a estas mejores prácticas puede ser determinante en el éxito del desarrollo de aplicaciones de inteligencia artificial generativa.