Compartir:

La inteligencia artificial sigue avanzando de manera impresionante, y los PCs Copilot+ se encuentran en la vanguardia de estos desarrollos tecnológicos. Gracias a la reciente integración de DeepSeek R1 en Azure AI Foundry, se han comenzado a lanzar versiones optimizadas para su ejecución en unidades de procesamiento neural (NPU) que vienen integradas en estos dispositivos. El lanzamiento inicial incluirá soporte para el Qualcomm Snapdragon X, seguido por el Intel Core Ultra 200V y otros procesadores similares. El primer modelo disponible será el DeepSeek-R1-Distill-Qwen-1.5B, accesible a través del AI Toolkit, con variantes más avanzadas de 7B y 14B previstas para ser lanzadas próximamente.

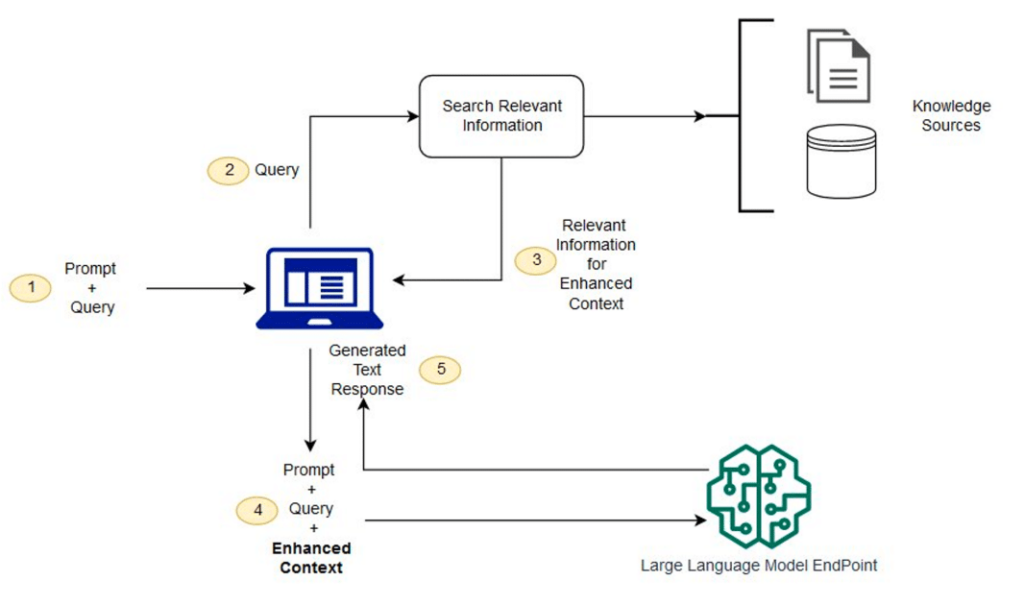

Estas versiones optimizadas están diseñadas para permitir a los desarrolladores crear y desplegar aplicaciones basadas en inteligencia artificial de manera eficiente directamente en los dispositivos, aprovechando al máximo las capacidades de las NPUs en los PCs Copilot+. Estas unidades ofrecen un motor capaz de realizar inferencias de modelos de manera sumamente eficaz, lo que abre nuevas oportunidades donde la inteligencia artificial generativa puede operar en un modo semi-continuo. Esta capacidad renovada habilita a los desarrolladores para crear experiencias proactivas y sostenidas, utilizando motores de razonamiento avanzados.

El trabajo realizado en Phi Silica ha sido esencial para lograr una eficientísima inferencia, con tiempos competitivos para el procesamiento del primer token y un rendimiento destacado, minimizando el impacto en la duración de la batería y el consumo de recursos del PC. Los modelos DeepSeek, optimizados para las NPUs, incorporan técnicas clave de este trabajo, incluyendo la separación estratégica de varias partes del modelo para equilibrar rendimiento y eficiencia y la implementación de una cuantización de baja tasa de bits.

Los desarrolladores ya tienen la oportunidad de experimentar con DeepSeek en sus PCs Copilot+ descargando la extensión de AI Toolkit para Visual Studio Code. Una vez instalada, tendrán acceso al conjunto de modelos DeepSeek en formato ONNX QDQ y podrán experimentar con sus capacidades y rendimiento fácilmente. Alternativamente, existe la posibilidad de utilizar el modelo fuente en la nube a través de Azure Foundry.

En términos de optimización del silicio, el modelo Qwen 1.5B incluye múltiples componentes como un tokenizador, una capa de incrustación, un modelo de procesamiento de contexto, un modelo de iteración de tokens y una cabeza de lenguaje. Se utilizan avanzadas técnicas de cuantización para optimizar las operaciones que requieren un alto acceso a la memoria en la CPU, mientras que las partes computativamente más intensivas se gestionan a través de la NPU.

El resultado es un modelo de IA extremadamente rápido y eficiente, que logra tiempos de respuesta de 130 milisegundos y una tasa de rendimiento de 16 tokens por segundo en respuestas cortas. Esto es posible gracias a un diseño innovador de ventana deslizante que maximiza el rendimiento y un esquema de cuantización que mejora la precisión en comparación con los métodos anteriores.

Con estas avanzadas capacidades, los usuarios podrán interactuar con modelos de IA de última generación directamente en sus dispositivos locales, revolucionando el desarrollo y la utilización de aplicaciones de inteligencia artificial en los ordenadores personales.