Compartir:

Los modelos de lenguaje de gran tamaño (LLMs) han transformado significativamente la capacidad de generar texto de manera que emule respuestas humanas, pero enfrentan un importante inconveniente: las «alucinaciones». Este problema surge cuando los modelos entregan respuestas que, aunque parecen coherentes y confiables, son incorrectas desde un punto de vista factual. A pesar de haber sido entrenados con enormes cantidades de datos, los LLMs frecuentemente carecen del conocimiento contextual específico y de la información actualizada que se requiere para ofrecer respuestas precisas, especialmente en escenarios empresariales.

Para mitigar este problema, las técnicas de Generación Aumentada por Recuperación (RAG) buscan anclar los LLMs en datos pertinentes durante el proceso de inferencia. Sin embargo, estos modelos aún pueden producir resultados no deterministas y, a veces, inventar información incluso cuando tienen acceso a material de origen preciso. Esto puede representar un riesgo significativo para las organizaciones que adoptan LLMs en aplicaciones de producción, particularmente en sectores críticos como la salud, las finanzas y los servicios legales, donde las alucinaciones pueden desencadenar desinformación, problemas legales y erosión de la confianza del usuario.

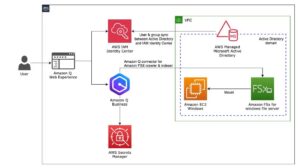

Para enfrentar estos desafíos, se ha desarrollado una solución que combina la flexibilidad de los LLMs con la confiabilidad de las respuestas verificadas y curadas. Esta solución se apoya en dos servicios clave de Amazon Bedrock: las Bases de Conocimientos, que facilitan el almacenamiento, búsqueda y recuperación de información organizacional específica, y los Agentes de Amazon Bedrock, que hacen posible la creación, prueba y despliegue de asistentes de inteligencia artificial capaces de interpretar solicitudes de usuarios y ejecutar acciones. Se asemeja a un sistema de atención al cliente que mantiene un repertorio de respuestas preparadas para preguntas frecuentes. La solución procesa primero la pregunta del usuario respecto a las respuestas verificadas antes de permitir que el LLM genere una nueva respuesta. Este enfoque ayuda a prevenir alucinaciones utilizando información confiable cuando está disponible, mientras que el LLM maneja nuevas preguntas.

El sistema se apoya en un «cache semántico verificado» que utiliza la API de Recuperación de Bases de Conocimiento de Amazon Bedrock para reducir las alucinaciones en las respuestas de los LLMs, mejorando simultáneamente la latencia y reduciendo costos. Este cache semántico actúa como una capa intermedia entre el usuario y los Agentes de Amazon Bedrock, almacenando pares verificados de preguntas y respuestas.

Al recibir una consulta, la solución evalúa su similitud semántica con las preguntas ya presentes en la base de conocimiento verificada. Si se encuentra una alta similitud, se devuelve la respuesta verificada sin activar al LLM. En casos de similitudes parciales, las respuestas verificadas guiadas se emplean para mejorar la precisión y consistencia del LLM. Cuando no existen coincidencias, se recurre al procesamiento convencional del LLM.

Esta estrategia conlleva varios beneficios, como la reducción de costos al minimizar llamadas innecesarias a LLMs, mejoras en la precisión de las respuestas debido a las verificaciones y una menor latencia mediante la recuperación directa de respuestas. A medida que se expande la base de datos de preguntas y respuestas, la solución se vuelve cada vez más confiable y eficiente en la gestión de consultas de usuarios.

Al implementar esta técnica, no solo se espera una mejora general en la precisión de las respuestas, sino también tiempos de respuesta más rápidos y una reducción significativa de costos. Integrando un cache semántico con LLMs, esta solución ofrece un camino sólido hacia la creación de aplicaciones de inteligencia artificial más confiables, asegurando que tanto los nuevos desarrolladores de IA como los profesionales experimentados cuenten con herramientas eficientes para su labor.