Compartir:

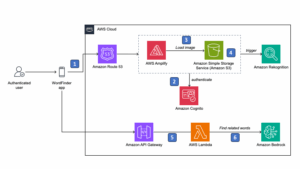

Las organizaciones que emplean agentes y sistemas basados en tecnología avanzada se enfrentan a retos notorios en la implementación de múltiples herramientas y la coordinación de flujos de trabajo. Un agente suele emplear funciones para convocar herramientas externas, como APIs o bases de datos, con el propósito de ejecutar acciones específicas o recuperar información.

El desafío radica en integrar estas herramientas de manera eficiente dentro del agente, un proceso que puede complicar la expansión y reutilización de dichas herramientas. Por ello, las empresas que desean desplegar agentes a gran escala necesitan una metodología uniforme para la integración, sin importar el sistema de orquestación utilizado.

En este contexto, el Protocolo de Contexto del Modelo (MCP) surge como una solución sofisticada que busca estandarizar la forma en que los canales, agentes, herramientas y datos de los clientes se conectan. Al simplificar estos procesos, MCP ofrece una experiencia más uniforme y eficiente, aliviando la necesidad de desarrollar código de integración personalizado.

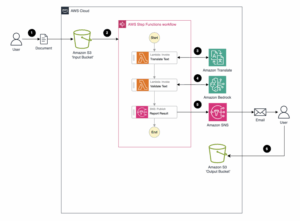

Para la implementación del MCP, es esencial contar con una infraestructura escalable capaz de alojar servidores y modelos de lenguaje grandes (LLM). Amazon SageMaker AI ofrece un entorno ideal para esto, permitiendo hosting sin preocuparse por el escalado o gestión operacional, facilitando así la implementación de servidores MCP en AWS, incluyendo Amazon EC2, Amazon ECS, Amazon EKS y AWS Lambda.

El MCP representa un avance en comparación con arquitecturas tradicionales de microservicios, que a menudo requieren integraciones individuales complejas. MCP, por su parte, ofrece una interfaz de comunicación en tiempo real que simplifica la conexión de sistemas de IA con herramientas externas, APIs y fuentes de datos, favoreciendo aplicaciones que requieran acceso modular y fiable a múltiples recursos.

Para implementar servidores MCP, opciones como FastAPI y FastMCP están disponibles. Mientras que FastMCP es ideal para desarrollos rápidos, FastAPI permite un control más detallado para flujos complejos.

Con esta arquitectura, las organizaciones pueden optimizar la integración de IA, recortando la necesidad de integraciones personalizadas y superando obstáculos de mantenimiento. La capacidad de conectar modelos de forma segura a sistemas críticos permite transformar operaciones, agilizar procesos y obtener valiosas perspectivas comerciales. Así, la evolución de la IA se ve impulsada por el MCP y el uso de Amazon SageMaker AI, estableciendo una base flexible para futuras innovaciones.