Compartir:

Las aplicaciones de inteligencia artificial generativa, impulsadas por grandes modelos de lenguaje (LLMs), están ganando rápidamente aceptación para casos de uso de respuesta a preguntas. Desde bases de conocimientos internas para el apoyo al cliente hasta asistentes de IA conversacionales externos, estas aplicaciones utilizan LLMs para proporcionar respuestas humanas a consultas en lenguaje natural. Sin embargo, construir y desplegar estos asistentes con las mejores prácticas de IA responsable requiere un marco sólido de verdad fundamental y evaluación para asegurar que cumplan con los estándares de calidad y las expectativas de experiencia del usuario, así como directrices claras de interpretación para que la calidad y la responsabilidad de estos sistemas sean comprensibles para los responsables empresariales.

Este artículo se centra en la evaluación e interpretación de métricas utilizando FMEval para la respuesta a preguntas en una aplicación de IA generativa. FMEval es una suite de evaluación integral de Amazon SageMaker Clarify que proporciona implementaciones estandarizadas de métricas para evaluar la calidad y la responsabilidad. Para conocer más sobre FMEval, se puede consultar el blog sobre «Evaluar grandes modelos de lenguaje para calidad y responsabilidad» en el sitio web de AWS.

Discutiremos las mejores prácticas para trabajar con FMEval en la curación de la verdad básica y la interpretación de métricas para evaluar aplicaciones de respuesta a preguntas por su conocimiento factual y calidad. Los datos de verdad básica en IA se refieren a datos que se sabe que son ciertos, representando el resultado esperado para el sistema que se está modelando. Proporcionando un resultado verdadero esperado contra el cual medir, los datos de verdad básica desbloquean la capacidad de evaluar determinísticamente la calidad del sistema. La curación de la verdad básica y la interpretación de métricas están íntimamente ligadas, y la implementación de la métrica de evaluación debe informar la curación de la verdad básica para obtener los mejores resultados. Al seguir estas directrices, los científicos de datos pueden cuantificar la experiencia del usuario que ofrecen sus flujos de trabajo de IA generativa y comunicar su significado a los interesados comerciales, facilitando comparaciones listas entre diferentes arquitecturas, tales como los flujos de trabajo de generación aumentada por recuperación (RAG), LLMs listos para usar o ajustados, o soluciones agentivas.

Resumen de la solución

Utilizamos un conjunto de datos de referencia (referido como el conjunto de datos dorado) de 10 tríadas de pregunta-respuesta-hecho. Cada tríada describe un hecho y una encapsulación del hecho como un par de pregunta-respuesta para imitar una respuesta ideal, derivada de un documento fuente de conocimiento. Usamos el informe 10Q del segundo trimestre de Amazon de 2023 como el documento fuente para crear las 10 tríadas de pregunta-respuesta-hecho. El informe 10Q contiene detalles sobre las finanzas y operaciones de la empresa durante el segundo trimestre de 2023. El conjunto de datos dorado aplica las mejores prácticas de curación de la verdad básica discutidas en este artículo para la mayoría de las preguntas, pero no todas, para demostrar el impacto descendente de la curación de la verdad básica en los resultados de las métricas.

Generamos respuestas de tres flujos de trabajo de IA generativa de RAG (anonimizados como Pipeline1, Pipeline2 y Pipeline3) y calculamos métricas de conocimiento factual y precisión de QA, evaluándolos frente al conjunto de datos dorado. La clave del hecho del tríada se usa para la métrica de conocimiento factual de verdad básica, y la clave de la respuesta se usa para la métrica de precisión de QA de verdad básica. Con esto, el conocimiento factual se mide contra la clave de hechos, y la experiencia del usuario ideal en términos de estilo y concisión se mide contra los pares de pregunta-respuesta.

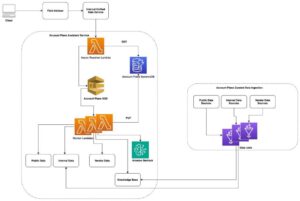

Evaluación para la respuesta a preguntas en una aplicación de IA generativa

Un flujo de trabajo de IA generativa puede tener muchos subcomponentes, como un flujo de trabajo RAG. RAG es una metodología para mejorar la precisión de las respuestas de LLM al responder una consulta del usuario recibiendo e insertando conocimiento de dominio relevante en la solicitud del modelo de lenguaje. La calidad de RAG depende de las configuraciones del retriever (fragmentación, indexación) y del generador (selección de LLM e hiperparámetros, plantilla de solicitud), como se ilustra en la figura siguiente. Ajustar la fragmentación y la indexación en el retriever asegura que el contenido correcto esté disponible en la solicitud del LLM para la generación. El tamaño del fragmento y el método de división del fragmento, así como los medios de incrustar y clasificar los fragmentos de documento relevantes como vectores en el almacén de conocimiento, influyen en si la respuesta real a la consulta finalmente se inserta en la solicitud. En el generador, seleccionar un LLM apropiado para ejecutar la solicitud y ajustar sus hiperparámetros y plantilla de solicitud, controlan cómo se interpreta la información recuperada para la respuesta. Con esto, cuando se evalúa una respuesta final de un flujo de trabajo RAG, los componentes precedentes pueden ser ajustados para mejorar la calidad de la respuesta.

Alternativamente, la respuesta a preguntas puede ser impulsada por un LLM ajustado, o a través de un enfoque agentivo. Aunque demostramos la evaluación de respuestas finales de flujos de trabajo RAG, las respuestas finales de un flujo de trabajo de IA generativa para la respuesta a preguntas pueden ser evaluadas de manera similar, ya que los requisitos previos son un conjunto de datos dorado y las respuestas generativas. Con este enfoque, los cambios en la salida generativa debido a diferentes arquitecturas de flujo de trabajo de IA generativa pueden ser evaluados para informar las mejores decisiones de diseño.

Aunque la evaluación de cada subcomponente de un flujo de trabajo de IA generativa es importante en el desarrollo y solución de problemas, las decisiones comerciales dependen de tener una vista de datos de extremo a extremo y lado a lado, cuantificando cómo un flujo de trabajo de IA generativa dado se desempeñará en términos de experiencia del usuario. Con esto, los responsables comerciales pueden entender los cambios esperados de calidad en términos de experiencia del usuario final al cambiar LLMs, y adherirse a requisitos legales y de cumplimiento, tales como la ética de IA de ISO42001. Hay beneficios financieros adicionales a realizar; por ejemplo, cuantificar los cambios esperados de calidad en conjuntos de datos internos al cambiar un LLM de desarrollo a un LLM ligero y más económico en producción. El proceso general de evaluación para el beneficio de los tomadores de decisiones se describe en la figura siguiente. En este artículo, nos centramos en la curación de la verdad básica, la evaluación y la interpretación de puntuaciones de evaluación para flujos de trabajo completos de IA generativa para la respuesta a preguntas utilizando FMEval para permitir la toma de decisiones basada en datos sobre la calidad.

Un modelo mental útil para la curación de la verdad básica y la mejora de un conjunto de datos dorado es un volante, como se muestra en la figura siguiente. El proceso de experimentación de la verdad básica implica consultar su flujo de trabajo de IA generativa con las preguntas iniciales del conjunto de datos dorado y evaluar las respuestas contra las respuestas doradas iniciales utilizando FMEval. Luego, la calidad del conjunto de datos dorado debe ser revisada por un juez. La revisión del juez sobre la calidad del conjunto de datos dorado acelera el volante hacia un conjunto de datos dorado cada vez mejor. El rol del juez en el flujo de trabajo puede ser asumido por otro LLM para habilitar la escalabilidad contra criterios establecidos y específicos del dominio para una verdad básica de alta calidad. Mantener un componente humano en el circuito para la función de juez sigue siendo esencial para muestrear y verificar resultados, así como para aumentar el estándar de calidad con tareas de complejidad creciente. La mejora del conjunto de datos dorado fomenta la mejora de la calidad de las métricas de evaluación, hasta que se alcance la precisión de medición suficiente en el volante por parte del juez, utilizando los criterios establecidos para la calidad. Para conocer más sobre las ofertas de AWS sobre la revisión humana de generaciones y el etiquetado de datos, como Amazon Augmented AI (Amazon A2I) y Amazon SageMaker Ground Truth Plus, consulte «Usando Amazon Augmented AI para revisión humana» y «Retroalimentación humana de alta calidad para sus aplicaciones de IA generativa de Amazon SageMaker Ground Truth Plus». Al usar LLMs como juez, asegúrese de aplicar las mejores prácticas de seguridad de solicitudes.

Sin embargo, para llevar a cabo revisiones de la calidad del conjunto de datos dorado como parte del volante de experimentación de la verdad básica, los revisores humanos deben entender la implementación de la métrica de evaluación y su acoplamiento a la curación de la verdad básica.

Métricas FMEval para la respuesta a preguntas en una aplicación de IA generativa

Las métricas de conocimiento factual y precisión QA de FMEval proporcionan una forma de evaluar conjuntos de datos de respuesta a preguntas personalizados contra la verdad básica. Para una lista completa de métricas implementadas con FMEval, consulte «Usando conjuntos de datos de solicitud y dimensiones de evaluación disponibles en trabajos de evaluación de modelos».

Las métricas de conocimiento factual y precisión QA miden la precisión factual y la calidad de las respuestas de los modelos de lenguaje y son cruciales para asegurar que las aplicaciones de IA generativa cumplan con los estándares de calidad y responsabilidad.