Compartir:

La inteligencia artificial generativa (IA generativa) está revolucionando la manera en que empresas y consumidores interactúan con datos, información y entre ellos mismos. En el primer acto de esta narrativa, se lograron modelos que mostraban el impresionante potencial de la IA generativa gracias a cantidades inimaginables de datos y poder de cómputo. El año pasado, muchas empresas y particulares se dedicaron al aprendizaje y experimentación con esta tecnología, realizando miles de pruebas para explorar sus aplicaciones y repercusiones.

Entramos ahora en el segundo acto, que marca el paso de las pruebas de concepto (POCs) a la producción, previsto para principios de 2024. Esta fase se enfoca en superar desafíos clave para evaluar y construir modelos específicos, buscando opciones más eficientes, rápidas y rentables. Este cambio impone una nueva eficiencia en el proceso complicado de construir, probar y afinar modelos fundamentales (FMs).

Para las empresas que buscan llevar sus aplicaciones de IA generativa a la producción, la oferta de múltiples puntos de entrada es crucial. La tecnología de AWS proporciona una arquitectura completa que permite construir y escalar aplicaciones de IA generativa. Desde Amazon Q, el asistente más avanzado para acelerar el desarrollo de software, hasta Amazon Bedrock y Amazon SageMaker, diseñados para ayudar a construir, entrenar y desplegar FMs.

Las organizaciones que desean control granular o construir sus propios modelos están optando por los servicios de AWS por su capacidad para usar el cloud de manera más eficiente y aprovechar funcionalidades más poderosas y rentables. La inversión profunda en estas capas mejora las capacidades y la eficiencia de los servicios proporcionados.

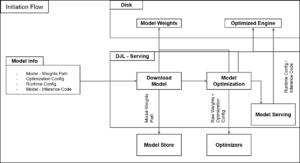

Para optimizar el uso de la IA generativa, se necesita una infraestructura elevada en rendimiento y costo-efectiva. Amazon SageMaker facilita este objetivo en cada etapa del ciclo de vida del modelo. Sin embargo, el entrenamiento y la inferencia de FMs presentan retos significativos, como la carga operativa, el coste total y la latencia en el rendimiento, que afectan la experiencia del usuario.

Reconociendo estos desafíos, AWS lanzó Amazon SageMaker HyperPod, diseñado para minimizar la carga operativa y acelerar el desarrollo de FMs a una escala sin precedentes. Ahora, con el soporte de Amazon EKS en Amazon SageMaker HyperPod, se permite a los desarrolladores gestionar estos clústeres usando una interfaz Kubernetes familiar, eliminando tareas complicadas y optimizando los clústeres para el desarrollo de modelos de IA generativa a gran escala.

Arun Subramaniyan, fundador y CEO de Articul8 AI, destaca el impacto positivo de esta innovación, que ha mejorado en hasta un 35% la productividad y facilitado la integración de la IA generativa en sus operaciones.

A pesar de los avances en la fase de inferencia, sigue siendo un cuello de botella significativo. AWS ha lanzado recientemente un kit de herramientas de optimización de inferencia en Amazon SageMaker, que promete hasta el doble de rendimiento y reducción de costos en un 50%, aplicando técnicas avanzadas de optimización.

La implementación segura y confiable de modelos es una preocupación crucial al pasar de pruebas a producción. Para abordar esto, Amazon Bedrock Guardrails proporciona salvaguardas personalizables para filtrar prompts y respuestas de modelos, reducir contenidos perjudiciales y mantener la información de identificación personal (PII) segura.

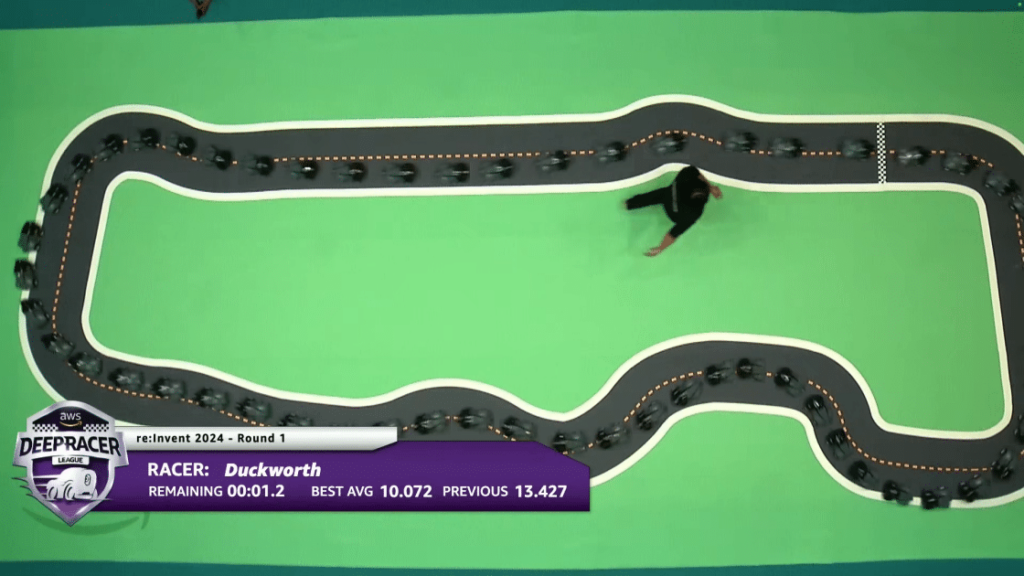

Una colaboración notable es la de AWS y la NFL, que ha llevado al desarrollo de Tackle Probability, una métrica impulsada por IA que analiza la probabilidad de tacleo en tiempo real, ofreciendo valiosos insights tanto a equipos como a seguidores del deporte.

AWS sigue liderando innovaciones, facilitando herramientas para democratizar la IA generativa desde grandes empresas hasta pequeños desarrolladores. Estas capacidades están impulsando una nueva ola de innovación, mejorando experiencias y creando valor significativo en diversos sectores.