Compartir:

Meta ha lanzado oficialmente su nuevo modelo de lenguaje, Llama 3.3 70B, que ya está disponible en Amazon SageMaker JumpStart. Este innovador desarrollo en el campo de los modelos de lenguaje grandes (LLM) se destaca por ofrecer un rendimiento comparable al de sus predecesores más robustos, utilizando, sin embargo, una cantidad de recursos notablemente menor. Esta eficiencia no solo representa una mejora en la calidad del modelo, sino también una significativa reducción de costos, transformándolo en una opción atractiva para las empresas que buscan soluciones efectivas para implementaciones de producción.

El modelo Llama 3.3 70B ha sido diseñado para operar de manera óptima, brindando resultados comparables a los obtenidos por el Llama 3.1 405B mientras consume solo una fracción de los recursos. Según Meta, esta eficiencia incrementada permite casi quintuplicar las operaciones de inferencia al mismo costo, lo cual ofrece una solución más económica para las organizaciones.

La arquitectura del modelo se basa en una versión mejorada del diseño de transformadores, que incluye un mecanismo de atención optimizado para reducir los costos de inferencia significativamente. Durante su desarrollo, el equipo de ingeniería de Meta entrenó el modelo utilizando un vasto conjunto de datos abarcando aproximadamente 15 billones de tokens. Estos datos incluyen contenido web combinado con más de 25 millones de ejemplos sintéticos creados específicamente para el avance de los LLM. Esta rigurosa metodología de entrenamiento ha dotado al modelo con una sólida capacidad para comprender y generar respuestas en una variedad amplia de tareas.

Llama 3.3 70B destaca por su metodología de entrenamiento refinada, que incorpora un proceso exhaustivo de ajuste supervisado y aprendizaje por refuerzo basado en retroalimentación humana (RLHF). Esta estrategia ha permitido al modelo alinеar sus salidas de manera más efectiva a las preferencias humanas, sin comprometer su rendimiento estándar. En pruebas de evaluación, Llama 3.3 70B demostró tener una consistencia notable, quedando a menos del 2% de diferencia en seis de diez evaluaciones estándar de inteligencia artificial en comparación con sus contrapartes más grandes, llegando incluso a superarlas en tres categorías.

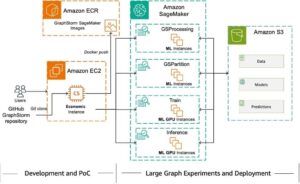

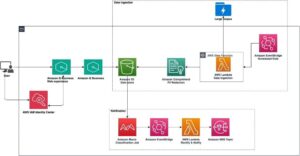

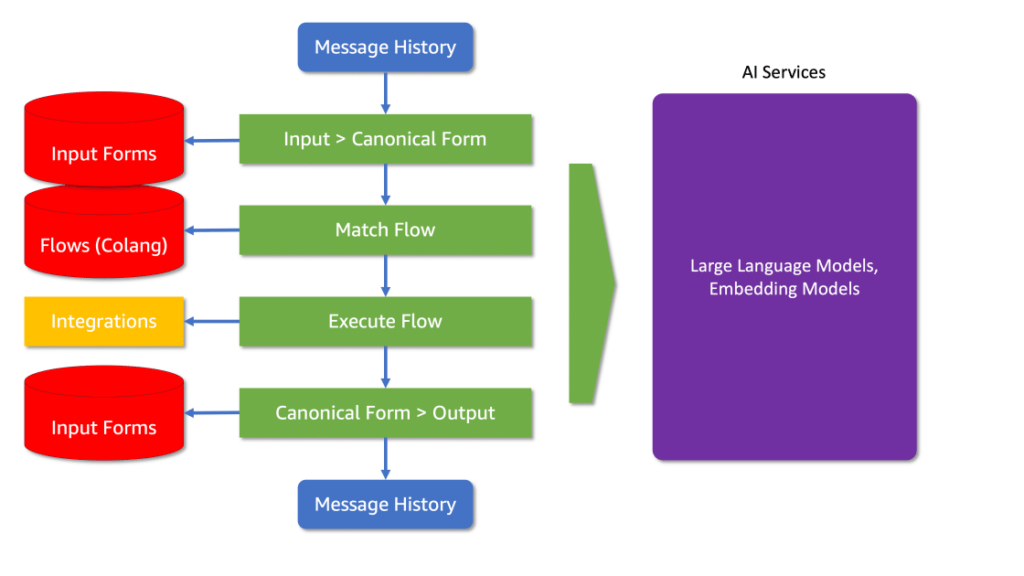

Para facilitar el despliegue del nuevo modelo, SageMaker JumpStart ofrece herramientas útiles que apoyan en la evaluación, comparación y selección de modelos preentrenados, como Llama. Los usuarios pueden implementar Llama 3.3 70B a través de una interfaz de usuario intuitiva o mediante un enfoque programático utilizando el SDK de Python de SageMaker, permitiendo así flexibilidad y escalabilidad para adaptarse a las necesidades específicas de cada organización.

SageMaker AI proporciona capacidades avanzadas como la carga rápida de modelos, almacenamiento en caché de contenedores y la posibilidad de escalar a cero, lo que permite a las organizaciones gestionar sus despliegues de manera eficiente, maximizando las ventajas de la arquitectura optimizada de Llama 3.3 70B sin incurrir en gastos innecesarios.

La combinación de las características avanzadas de Llama 3.3 70B con las herramientas de implementación de SageMaker AI ofrece una solución ideal para las organizaciones que buscan optimizar tanto el rendimiento como la eficiencia de costos en sus operaciones relacionadas con el modelado de lenguaje.