Compartir:

La Generación Aumentada por Recuperación (RAG) es una técnica poderosa que puede ayudar a las empresas a desarrollar aplicaciones de inteligencia artificial generativa (IA) que integren datos en tiempo real y permitan conversaciones ricas e interactivas utilizando datos propios. RAG permite que estas aplicaciones de IA accedan a fuentes externas y confiables de conocimientos específicos del dominio, enriqueciendo el contexto para el modelo de lenguaje a medida que responde a las consultas del usuario. Sin embargo, la fiabilidad y precisión de las respuestas dependen de encontrar las fuentes correctas de información. Por lo tanto, perfeccionar el proceso de búsqueda en RAG es crucial para aumentar la confianza en las respuestas generadas.

Los sistemas RAG son herramientas importantes para construir sistemas de búsqueda y recuperación, pero a menudo no cumplen con las expectativas debido a pasos de recuperación subóptimos. Esto puede mejorarse utilizando un paso de reordenamiento para mejorar la calidad de la búsqueda.

RAG es un enfoque que combina técnicas de recuperación de información con procesamiento de lenguaje natural (NLP) para mejorar el desempeño de tareas de generación de texto o modelado de lenguaje. Este método implica recuperar información relevante de un gran corpus de datos textuales y utilizarla para aumentar el proceso de generación. La idea clave es incorporar conocimiento externo o contexto en el modelo para mejorar la precisión, diversidad y relevancia de las respuestas generadas.

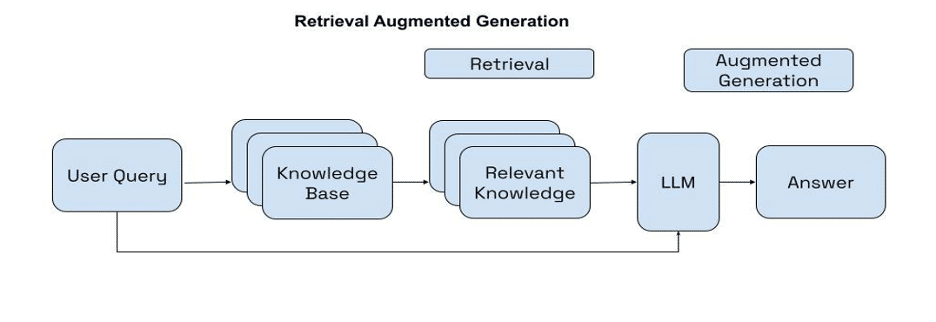

El flujo de trabajo de la orquestación RAG generalmente consta de dos pasos:

1. Recuperación: RAG recupera documentos relevantes de una fuente de datos externa utilizando las consultas de búsqueda generadas.

2. Generación fundamentada: Utilizando los documentos o pasajes recuperados, el modelo de generación crea respuestas educadas con citas en línea usando los documentos obtenidos.

Una técnica para recuperar documentos en una orquestación RAG es la recuperación densa, que tiene como objetivo comprender el significado semántico y la intención detrás de las consultas del usuario. La recuperación densa encuentra los documentos más cercanos a una consulta de usuario en el espacio de incrustaciones, mapeando tanto las consultas del usuario como los documentos (o pasajes) en un espacio de vectores densos.

Para abordar los desafíos con la precisión, los ingenieros de búsqueda han utilizado la recuperación en dos etapas como un medio para aumentar la calidad de la búsqueda. En estos sistemas de dos etapas, un modelo de primera etapa (un modelo de incrustación o recuperador) recupera un conjunto de documentos candidatos de un conjunto de datos más grande. Luego, un modelo de segunda etapa (el reordenador) se utiliza para reordenar esos documentos recuperados por el modelo de primera etapa. Un modelo de reordenamiento, como Cohere Rerank, es un tipo de modelo que genera una puntuación de similitud cuando se le da un par de consulta y documento. Este puntaje se puede utilizar para reordenar los documentos más relevantes para la consulta de búsqueda.

Cohere Rerank busca reevaluar y reordenar la relevancia de los documentos recuperados en función de criterios adicionales, como el contenido semántico, la intención del usuario y la relevancia contextual, para generar una puntuación de similitud. Esta puntuación se utiliza luego para reordenar los documentos según la relevancia de la consulta.

Aplicando Cohere Rerank después de la recuperación de primera etapa, la orquestación RAG puede beneficiarse de ambos enfoques. Mientras que la recuperación de primera etapa ayuda a capturar elementos relevantes basados en coincidencias de proximidad dentro del espacio vectorial, el reordenamiento ayuda a optimizar la búsqueda garantizando que los resultados contextualmente relevantes se presenten en la parte superior.

La última versión de Cohere Rerank, Rerank 3, está diseñada específicamente para mejorar la búsqueda empresarial y los sistemas RAG. Rerank 3 ofrece capacidades de última generación para la búsqueda empresarial, incluyendo una longitud de contexto de 4k para mejorar significativamente la calidad de la búsqueda para documentos más largos, la capacidad de buscar sobre datos multi-aspecto y semi-estructurados, cobertura multilingüe de más de 100 idiomas y una mejor latencia y menor costo total de propiedad (TCO).

Los desarrolladores y negocios pueden acceder a Rerank en la API hospedada de Cohere y en Amazon SageMaker.

Para implementar Rerank 3 en Amazon SageMaker, es necesario suscribirse al paquete del modelo y crear un punto final para realizar inferencias en tiempo real. La suscripción se realiza a través de AWS Marketplace, y para crear el punto final se utiliza un conjunto de documentos y una consulta para generar una puntuación de relevancia que permite visualizar los resultados de manera eficiente y precisa.

En resumen, RAG es una técnica eficaz para desarrollar aplicaciones de IA que integren datos en tiempo real y permitan interacciones enriquecidas utilizando información propietaria. La efectividad de RAG depende de la calidad de los materiales fuente recuperados, y Cohere Rerank ayuda a optimizar este proceso mediante la evaluación y reordenamiento de documentos basados en criterios semánticos y contextuales.