Compartir:

Karini AI ha dado un nuevo paso en la transformación digital de las empresas al ofrecer una plataforma robusta y fácil de usar para construir, gestionar y desplegar aplicaciones de inteligencia artificial generativa (GenAI). Esta plataforma, desarrollada sobre AWS, permite tanto a principiantes como a expertos crear y poner en funcionamiento aplicaciones de GenAI para diversos casos de uso, incluyendo chatbot, business intelligence generativa y flujos de trabajo por lotes.

A pesar de que los proyectos piloto utilizando GenAI pueden comenzar sin dificultad, muchas empresas enfrentan retos para avanzar más allá de esta fase. Según Everest Research, más del 50% de los proyectos no progresan debido a la falta de prácticas operativas estandarizadas para GenAI. En este contexto, Karini AI surge como una solución ideal para superar estas barreras.

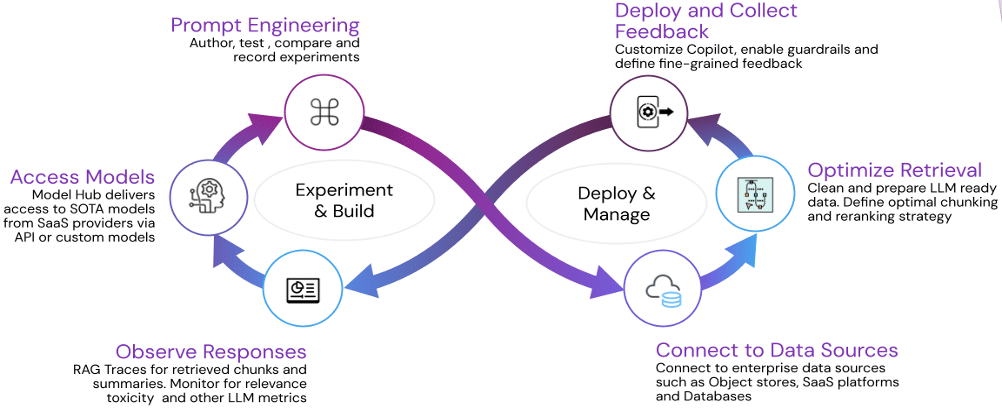

La plataforma de Karini AI presenta varias características que la hacen versátil y eficiente. Entre ellas, un marco de evaluación de calidad que permite evaluar y monitorear la calidad durante y después del despliegue, un playground intuitivo para la creación y gestión de prompts, y recetas sin código para montar pipelines de ingestión de datos y desplegar cadenas agenticas. Además, la integración con Amazon Bedrock permite inferencia con modelos de lenguaje grande (LLM), aprovechando conectores empresariales extensos y técnicas avanzadas de preprocesamiento de datos.

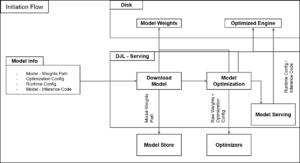

Una de las innovaciones más significativas implementadas por Karini AI ha sido la migración de sus modelos de incrustación vectorial de Kubernetes a endpoints de Amazon SageMaker. Esta transición no solo mejoró la concurrencia en un 30%, sino que también permitió un ahorro del 23% en costos de infraestructura.

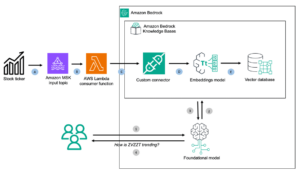

Enriquecer modelos de lenguaje grandes (LLM) con nuevos datos es crucial para el desarrollo de aplicaciones generativas prácticas. Para ello, Karini AI utiliza «Retrieval Augmented Generation» (RAG), una técnica que mejora el rendimiento en tareas intensivas en conocimiento al incorporar datos externos.

El pipeline de ingestión de datos de Karini AI permite la conexión a múltiples fuentes de datos, convirtiéndolas en incrustaciones vectoriales que luego se almacenan en una base de datos vectorial para su recuperación. Esta flexibilidad es posible gracias a la oferta de diversos modelos de incrustación en su hub de modelos, facilitando la creación de aplicaciones de inteligencia artificial avanzada.

Antes de migrar a SageMaker, Karini AI enfrentaba diversos desafíos con su infraestructura basada en Kubernetes, como la gestión complicada de modelos de estado del arte y la dificultad para mantener una concurrencia dinámica elevada. La adopción de Amazon SageMaker les permitió superar estos retos, aumentando la eficiencia y reduciendo costos.

Amazon SageMaker se ha convertido en una herramienta estratégica para Karini AI, permitiéndoles escalar de forma eficiente y cumplir con los acuerdos de nivel de servicio (SLA) de sus clientes, a la vez que optimizan su infraestructura y recursos.

Integrar SageMaker no solo ha permitido a Karini AI reducir su deuda técnica, sino que también ha facilitado un enfoque más eficaz y rentable para la creación y despliegue de modelos. Además, la compatibilidad de Karini AI con Amazon Bedrock para la inferencia LLM proporciona una solución holística para las necesidades de IA generativa.

En conclusión, la migración a Amazon SageMaker ha sido una decisión transformadora para Karini AI, mejorando su rendimiento y reduciendo costos significativamente. La capacidad de desplegar modelos personalizados y optimizar la configuración de infraestructura según las necesidades ha permitido a Karini AI adaptarse eficientemente a la creciente complejidad de los datos y las necesidades de concurrencia, asegurando así que sus clientes puedan aprovechar las últimas tecnologías de IA sin comprometer el rendimiento ni incurrir en costos innecesarios.