Compartir:

La inteligencia artificial generativa está transformando la operación y comunicación en organizaciones empresariales, permitiendo la creación de aplicaciones innovadoras que mejoran tanto la experiencia del cliente como la del empleado. Desde la automatización inteligente de documentos hasta la personalización de contenido de marketing, las empresas están implementando estas soluciones en sus procesos diarios para optimizar tareas y servicios.

En este innovador panorama, las grandes organizaciones, que suelen gestionar varias unidades de negocio (LOBs), están utilizando Amazon Web Services (AWS) con una estrategia de múltiples cuentas para centralizar la supervisión y administración. Se han establecido «zonas de aterrizaje» que facilitan la creación de cuentas seguras y la gestión automatizada de los entornos operativos. A pesar de que cada LOB opera con autonomía, un equipo centralizado, conocido como Centro de Excelencia en la Nube (CCoE), se encarga de supervisar los permisos de acceso y las políticas de gobernanza.

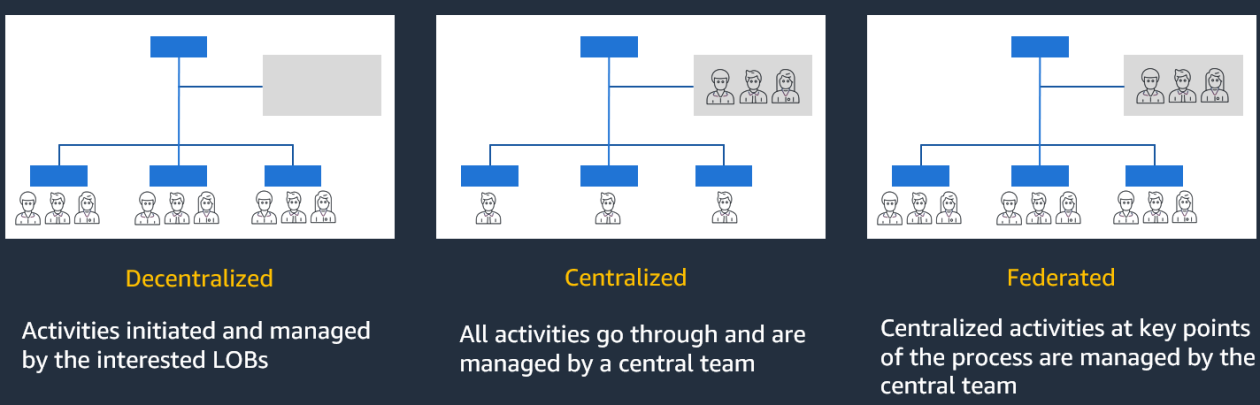

La adopción de la IA generativa ha obligado a las organizaciones a definir modelos operativos que estructuren su uso, abarcando diseño organizacional, procesos fundamentales, tecnologías, roles necesarios, estructuras de gobernanza y modelos financieros. Dependiendo de sus prioridades, las organizaciones pueden elegir entre tres patrones de modelo operativo: descentralizado, centralizado o federado.

El modelo descentralizado otorga a las LOBs la libertad para gestionar el desarrollo y despliegue de la IA generativa de manera independiente, mejorando la agilidad pero requiriendo alineación con los controles de gobernanza central para escalar las soluciones. En contraste, el modelo centralizado centraliza toda actividad de IA generativa en un equipo especializado, permitiendo estandarización y control, aunque podría generar retrasos y cuellos de botella.

El modelo federado equilibra el control central y la autonomía de las LOBs. Este enfoque permite a las unidades de negocio experimentar e innovar en sus propios entornos, mientras que un equipo central supervisa la seguridad y cumplimiento normativo, aprovechando el conocimiento especializado de cada LOB y manteniendo los estándares de calidad y gobernanza.

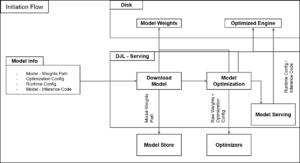

Para implementar estos modelos, las organizaciones deben considerar componentes de arquitectura y servicios que faciliten la IA generativa. Los modelos de lenguaje grande (LLMs) son esenciales, aunque presentan desafíos como respuestas incorrectas. Las técnicas de generación aumentada por recuperación (RAG) pueden mejorar la precisión combinando recuperación de información con modelos generativos.

Mecanismos de filtrado pueden ser aplicados para asegurar la privacidad y calidad del contenido alineando la interacción entre usuario e IA con las políticas empresariales. Además, la gestión de costos es crucial, y herramientas de AWS permiten seguir el uso y gastos relacionados.

En un entorno empresarial dinámico, adaptarse rápidamente a los avances en IA generativa es vital. Los modelos operativos federados ofrecen una efectiva forma de innovar y experimentar, mientras que un equipo centralizado asegura las mejores prácticas y estándares de gobernanza. Con herramientas como Amazon Bedrock, las empresas acceden a una plataforma sólida para construir y escalar aplicaciones de inteligencia artificial generativa, facilitando su avance hacia la transformación digital.