Compartir:

En el dinámico mundo de la inteligencia artificial (IA), los modelos generativos están revolucionando cómo los usuarios abordan la creatividad y la resolución de problemas. Estos sistemas avanzados han trascendido las capacidades textuales tradicionales y ahora integran funciones multimodales que expanden su aplicación a múltiples campos. Ya no se limitan a la generación de texto; ahora también crean imágenes sorprendentes, generan resúmenes atractivos, responden a preguntas complejas e incluso desarrollan código, todo con un alto nivel de precisión y coherencia. Esta integración multimodal abre nuevas posibilidades tanto para empresas como para individuos, impactando áreas como la creación de contenido, análisis visual y desarrollo de software.

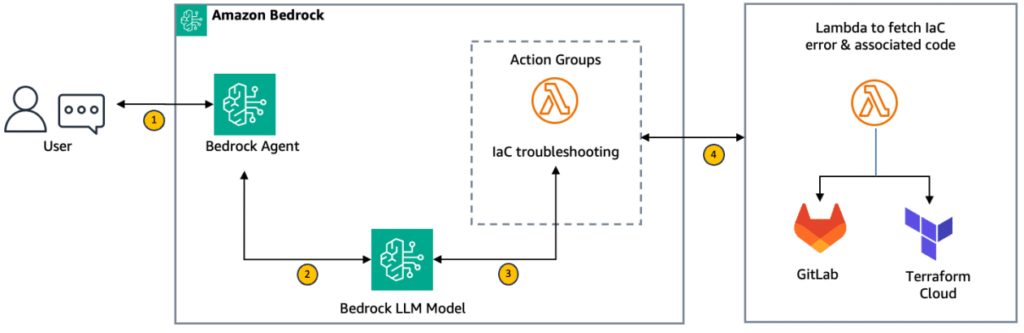

Un ejemplo de esta evolución se refleja en la implementación de los modelos Meta Llama 3.2, que incorporan capacidades de instrucción visual. Diseñados para tareas de respuesta a preguntas visuales, han mostrado un rendimiento destacado en el punto de referencia DocVQA, que evalúa imágenes de documentos con preguntas en lenguaje natural. Los modelos Meta Llama 3.2, incluso sin ajuste fino previo, lograron puntuaciones ANLS de 88.4 y 90.1. Gracias al ajuste fino con Amazon SageMaker JumpStart, estas puntuaciones se incrementaron a 91 y 92.4, respectivamente. Este proceso subraya cómo los sistemas de IA multimodal pueden ser equipados con habilidades especializadas para comprender y responder preguntas complejas sobre información visual contenida en documentos.

La colección Meta Llama 3.2, con modelos de 11B y 90B parámetros, es notable por ser la primera en incluir soporte para tareas de visión, integrando representaciones codificadoras de imágenes dentro del modelo de lenguaje. Estos modelos están diseñados para ser más eficientes, reduciendo la latencia y mejorando el rendimiento, factores que los hacen adecuados para una amplia gama de aplicaciones. Además, cuentan con soporte multilingüe mejorado para ocho idiomas, entre ellos inglés, alemán, francés, italiano, portugués, hindi, español y tailandés, ampliando así su aplicabilidad global.

DocVQA se ha establecido como un punto de referencia crucial para medir el rendimiento de modelos multimodales en la tarea de responder preguntas visuales con imágenes de documentos. Este recurso recopila imágenes de documentos junto con preguntas que requieren tanto comprensión visual como textual. Al afinar un modelo generativo de IA como Meta Llama 3.2 en este conjunto de datos mediante herramientas como Amazon SageMaker, se dota al modelo de las habilidades necesarias para sobresalir en estas tareas complejas, armonizando la capacidad de la IA para integrar y procesar datos diversos de manera efectiva.

Este avance representa un cambio significativo hacia la entrega de modelos de IA más eficientes, capaces de manejar grandes volúmenes de contexto—hasta 128,000 tokens—lo cual, junto con otras mejoras, potencia el rendimiento de los modelos en aplicaciones prácticas del mundo real.