Compartir:

Amazon Web Services (AWS) ha introducido una innovadora característica dentro de su plataforma Amazon Bedrock, denominada «Model Distillation». Este avance técnico está diseñado para proporcionar a las empresas modelos de inteligencia artificial (IA) más eficientes y rentables, sin comprometer la precisión. La característica se centra en utilizar modelos más pequeños, ágiles y específicos, ideales para ciertos casos de uso, asegurando una precisión comparable a los modelos más sofisticados de Amazon Bedrock.

El proceso de destilación de modelos es una técnica mediante la cual se transfiere conocimiento de un modelo complejo y avanzado, conocido como «maestro», a uno más compacto llamado «estudiante». Este modelo estudiante, al ser más pequeño, facilita rapidez y eficiencia en los costos, logrando rendir de manera efectiva en aplicaciones específicas. Para llevar a cabo esta transferencia de conocimiento, se emplean comandos personalizados que generan respuestas del modelo maestro, las cuales se utilizan para afinar el ajuste del modelo estudiante.

Amazon Bedrock se presenta como la plataforma que puede respaldar esta nueva característica, ofreciendo una variedad de modelos fundacionales de alta calidad y herramientas de desarrollo para aplicaciones de IA generativa. Con la destilación de modelos, Amazon Bedrock permite la personalización de modelos para satisfacer necesidades específicas mediante el uso de datos sintéticos generados por modelos avanzados. Actualmente, esta funcionalidad es compatible con tres proveedores de modelos: Amazon, Anthropic y Meta, y exige que tanto el modelo maestro como el estudiante sean del mismo proveedor.

Los beneficios principales de esta característica incluyen mayor eficiencia, optimización de costos, personalización avanzada y facilidad de uso. Los modelos destilados no solo mantienen una precisión específica para los casos de uso similar a los modelos más potentes, sino que también son tan rápidos como los más pequeños. Además, el proceso de inferencia es más económico que con modelos grandes y complejos. Amazon Bedrock automatiza la creación de conjuntos de entrenamiento de calidad sin requerir etiquetado manual.

Los usos potenciales de la destilación de modelos son diversos y pueden tener un impacto significativo en variadas aplicaciones. En la generación de búsqueda aumentada (RAG), se facilita la búsqueda y recuperación a gran escala. Para la automatización de resúmenes documentales, se ofrece el procesamiento de grandes volúmenes de contenido empresarial en tiempo real. En el ámbito de los chatbots, la capacidad para manejar múltiples conversaciones al mismo tiempo se fortalece, reduciendo los costos operativos. Para la clasificación de texto, es posible construir modelos que categoricen grandes volúmenes de tickets de soporte o retroalimentación de clientes de manera veloz.

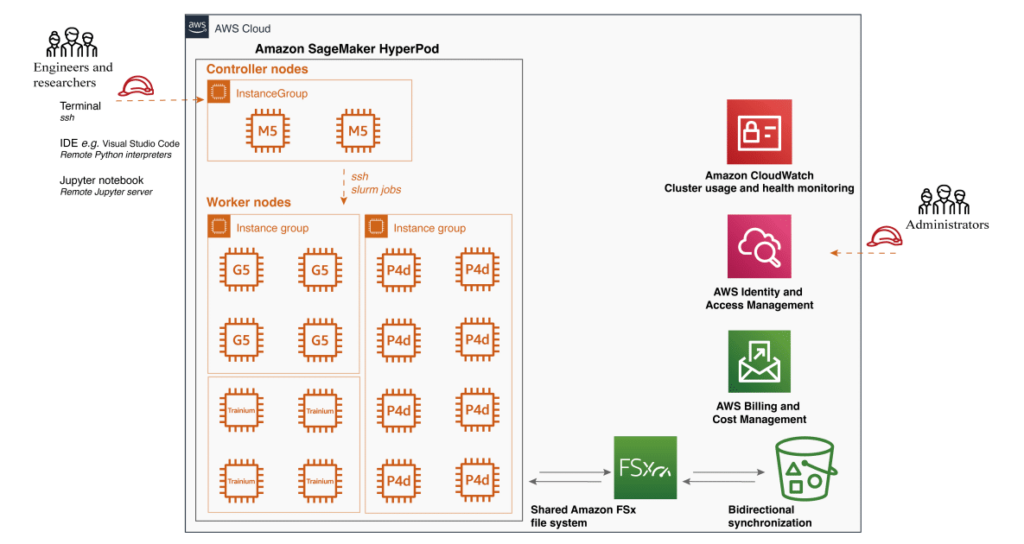

El flujo de trabajo comienza desde la selección de los modelos adecuados considerando rendimiento, latencia y costo, hasta el ajuste de los datos de entrada para su destilación. Después de implementar y evaluar los modelos destilados, las empresas pueden adquirir una capacidad de procesamiento personalizada, beneficiándose de las capacidades mejoradas del modelo.

Con «Model Distillation» de Amazon Bedrock, las empresas tienen la oportunidad de aprovechar el poder de modelos fundacionales a la vez que optimizan la latencia, los costos y los recursos, impulsando la innovación en IA en industrias como los servicios financieros, moderación de contenido, salud y atención al cliente. Esta iniciativa representa un paso significativo hacia soluciones de IA más accesibles y personalizadas, invitando a las organizaciones a explorar oportunidades innovadoras centradas en la eficiencia.