Compartir:

La inteligencia artificial generativa ha experimentado un auge notable, destacándose herramientas como la Generación Aumentada por Recuperación (RAG) por su capacidad para mejorar la precisión y fiabilidad de las respuestas generadas. RAG integra datos adicionales no considerados originalmente en el entrenamiento de los modelos de lenguaje, lo que ayuda a mitigar la emisión de información falsa o engañosa, conocidas en el ámbito de la IA como «alucinaciones».

Con la creciente integración de estos sistemas de IA en la vida cotidiana y en procesos críticos de toma de decisiones, la habilidad para detectar y contrarrestar estas alucinaciones se vuelve esencial. Las técnicas de detección actuales suelen centrarse en la pregunta y la respuesta, pero el contexto adicional que ofrece RAG permite el desarrollo de nuevos métodos que abordan este desafío con mayor eficacia.

Entre los métodos para crear un sistema básico de detección de alucinaciones en aplicaciones RAG, se ha realizado un análisis de sus pros y contras, evaluando aspectos como precisión, recuperación y coste. Las técnicas avanzadas en desarrollo buscan proporcionar métodos accesibles que puedan incorporarse fácilmente en las canalizaciones de RAG, mejorando así la calidad de las respuestas generadas.

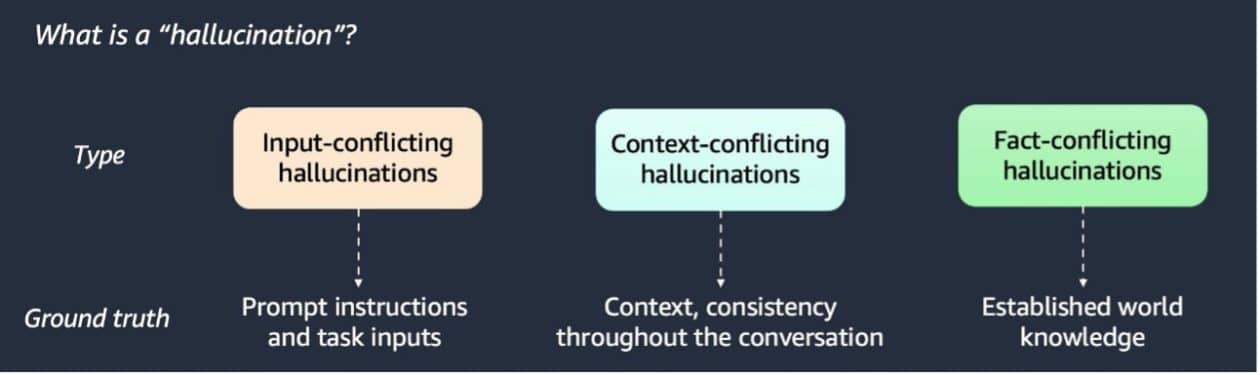

Se reconocen tres tipos de alucinaciones, y se han propuesto diversas técnicas para su detección, incluyendo detectores basados en LLM, sistemas de similitud semántica y el verificador estocástico BERT. Estos métodos han mostrado variada eficacia en términos de rapidez y rendimiento al ser probados con conjuntos de datos como artículos de Wikipedia y datos sintéticos.

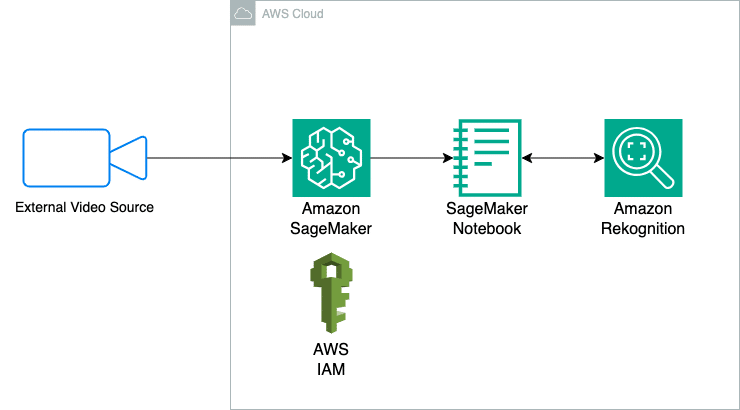

Para implementar eficientemente un sistema RAG, se requiere una cuenta en AWS con acceso a herramientas como Amazon SageMaker y Amazon S3, elementos cruciales para almacenar el contexto relevante, las preguntas y las respuestas generadas.

El método de detección basado en LLM clasifica las respuestas del sistema RAG analizando posibles conflictos con el contexto dado, mientras que las técnicas de similitud semántica y comparación de tokens ofrecen enfoques alternativos para identificar inconsistencias. El verificador estocástico BERT ha demostrado un alto rendimiento en la recuperación de información, aunque con costes elevados.

Comparaciones entre las técnicas sugieren que el enfoque basado en LLM ofrece un buen equilibrio entre precisión y coste. Por tanto, se recomienda emplear un enfoque híbrido que combine detectores de similitud de tokens con LLM para abordar eficazmente las alucinaciones, enfatizando la necesidad de adaptabilidad y análisis en las aplicaciones de inteligencia artificial generativa.

En última instancia, a medida que las aplicaciones de RAG evolucionan, los métodos para detectar alucinaciones se perfilan como herramientas esenciales para aumentar la fiabilidad y confianza en estos sistemas.