Compartir:

Thomson Reuters (TR), una de las organizaciones de información más confiables del mundo, ha logrado en su división de investigación, Thomson Reuters Labs (TR Labs), notables avances en la implementación de procesos de operaciones de aprendizaje automático (MLOps). Estos esfuerzos han sido facilitados mediante la adopción de un marco de trabajo estandarizado que utiliza soluciones basadas en Amazon Web Services (AWS), como SageMaker, SageMaker Experiments, SageMaker Model Registry y SageMaker Pipelines.

TR Labs, dedicada a la investigación aplicada y al desarrollo de la inteligencia artificial (IA) y otras tecnologías emergentes, ha enfrentado desafíos significativos a medida que la empresa ha crecido. Los equipos de TR Labs, que comenzaron modestamente y ahora incluyen más de 150 científicos aplicados, especialistas en aprendizaje automático e ingenieros, tuvieron que lidiar con un proceso de desarrollo y entrenamiento de modelos cada vez más complejo y difícil de gestionar.

Originalmente, los investigadores trabajaban con configuraciones personalizadas y código repetitivo, lo que resultaba en poca estandarización y eficiencia. Reconociendo la necesidad de un cambio, la dirección de TR Labs implementó un conjunto armonizado y estandarizado de herramientas MLOps, bautizado como TR MLTools, que buscaba simplificar y acelerar el proceso de desarrollo de modelos.

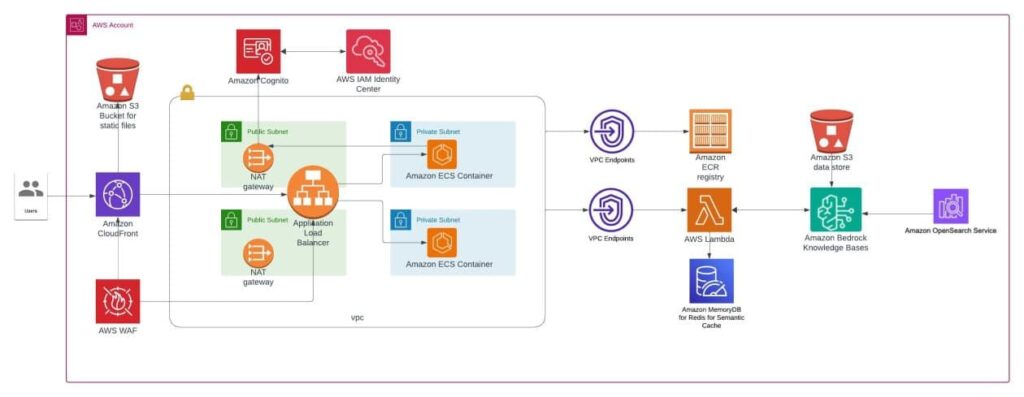

MLTools y MLTools CLI, un paquete Python y herramienta de línea de comandos, facilitan el flujo de trabajo de experimentos de aprendizaje automático (ML) de TR Labs. Estas herramientas proporcionan plantillas de código y configuración, consolidando el entorno de trabajo y promoviendo una reutilización efectiva del código. Esto ha permitido a los equipos crear nuevos experimentos, realizar pruebas y ejecutar scripts definidos por los usuarios a escala mediante trabajos en SageMaker.

El beneficio más notable de este enfoque estandarizado ha sido la aceleración en el desarrollo de modelos, reduciendo el tiempo necesario desde la ideación hasta la producción. El nuevo marco también mejora la colaboración entre investigadores y ML engineers, asegurando un flujo continuo y sin fricciones desde la etapa de experimentación hasta la implementación y mantenimiento en producción.

Además de mejorar los tiempos de desarrollo, la estandarización ha permitido identificar y corregir errores y drifts en el rendimiento de los modelos de manera más eficiente, lo que ha resultado en ahorro de costos significativos. La implementación de un proceso uniforme ha evitado la necesidad de repetición de tareas manuales y configuraciones individualizadas, reduciendo el tiempo dedicado a labores redundantes y complejas.

Para medir el éxito de este innovador enfoque, TR Labs emplea evaluaciones periódicas con los usuarios de las herramientas, que han revelado mejoras en la productividad percibida en hasta un 40% en varias áreas del ciclo de vida de la IA/ML. Esto ha aumentado la retención de talento y la satisfacción general del usuario.

En resumen, la adopción de un marco estandarizado de MLOps ha permitido a TR Labs optimizar enormemente su proceso de desarrollo de modelos de IA, disminuyendo tiempos de mercado y acelerando el valor del negocio obtenido mediante el desarrollo tecnológico. Aquellos interesados en conocer más acerca de cómo AWS puede asistir en sus viajes de IA/ML y MLOps pueden visitar la página de Amazon SageMaker.