Compartir:

La evaluación de los modelos de lenguaje de gran tamaño (LLM) ha adquirido una nueva dimensión en el paisaje tecnológico actual, con la introducción de un innovador marco denominado «LLM-as-a-judge». Este nuevo enfoque está transformando la manera en que las organizaciones valoran el desempeño de sus sistemas de inteligencia artificial, permitiéndoles aprovechar al máximo la rápida evolución de esta tecnología.

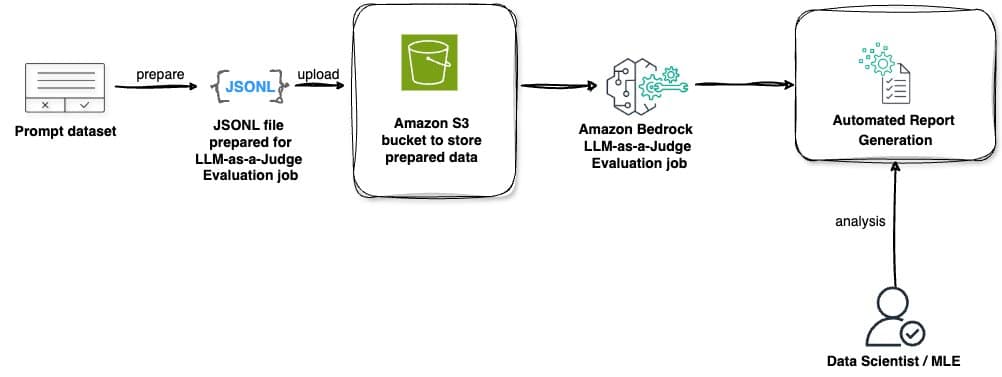

El método «LLM-as-a-judge» ha sido diseñado para simplificar y optimizar el proceso de evaluación de modelos de IA. Gracias a este marco, las empresas pueden evaluar la efectividad de sus modelos a través de métricas predefinidas que aseguran la alineación con sus necesidades y objetivos específicos. Esta capacidad de medición precisa del rendimiento permite a las organizaciones tomar decisiones informadas sobre la selección, optimización y despliegue de modelos de IA, mejorando así la fiabilidad y eficiencia de sus aplicaciones.

Una de las plataformas pioneras en adoptar estas capacidades es Amazon Bedrock. Este servicio, totalmente gestionado, ofrece modelos fundacionales de alto rendimiento de destacados proveedores de IA, integrados a través de una única API. Recientemente, ha dado a conocer dos capacidades significativas de evaluación: el uso del enfoque «LLM-as-a-judge» en su Evaluación de Modelos y la evaluación RAG para sus Bases de Conocimiento. Ambas funcionalidades utilizan el marco «LLM-as-a-judge» como soporte, aunque cada una se centra en diferentes aspectos de la evaluación.

Esta metodología se caracteriza por ofrecer una evaluación automática inteligente que logra una calidad comparable a la evaluación humana, pero con ahorros de costos que alcanzan hasta el 98%. En particular, el sistema abarca áreas clave como la calidad, experiencia del usuario, cumplimiento de instrucciones y seguridad. La integración con Amazon Bedrock permite a los usuarios acceder fácilmente a estas funcionalidades a través de la consola de gestión de AWS, incorporando incluso sus propios conjuntos de datos personalizados para una evaluación más ajustada.

El marco «LLM-as-a-judge» se presenta como una solución integral que no solo optimiza el rendimiento de los modelos de IA, sino que también garantiza altos estándares de calidad y seguridad. Para las empresas, esta tecnología asegura que sus aplicaciones de inteligencia artificial no solo sean efectivas en términos operativos, sino que estén alineadas con sus objetivos estratégicos, ofreciendo un enfoque más estratégico para la adopción de IA en sus procesos.