Compartir:

En un esfuerzo por expandir las capacidades de inteligencia artificial (IA) y procesamiento del lenguaje natural en aplicaciones empresariales, el equipo de Model Serving de Salesforce ha concentrado sus esfuerzos en la optimización de modelos de lenguaje de gran tamaño (LLMs) a través de la integración de soluciones avanzadas y la colaboración con líderes tecnológicos en el sector. Abarcando no solo modelos de aprendizaje automático tradicionales, su enfoque también incluye inteligencia artificial generativa, además de modelos de reconocimiento de voz y visión por computadora.

Una de las tareas principales del equipo es la gestión integral de los modelos, abarcando desde la recopilación de requisitos hasta la optimización y el escalado de los modelos de IA creados por los equipos de ciencia de datos e investigación de Salesforce. Este esfuerzo pone especial énfasis en la minimización de la latencia y maximización del rendimiento en el despliegue de estos modelos en múltiples regiones de AWS.

Sin embargo, Salesforce enfrenta desafíos importantes al implementar dichos modelos. El mayor de ellos es encontrar un equilibrio entre la reducción de latencia y el rendimiento sin comprometer la eficiencia de costos, un factor crítico en un entorno empresarial que exige respuestas rápidas y precisas. La optimización del rendimiento, junto con el aseguramiento de la seguridad y protección de datos del cliente, son también consideraciones fundamentales.

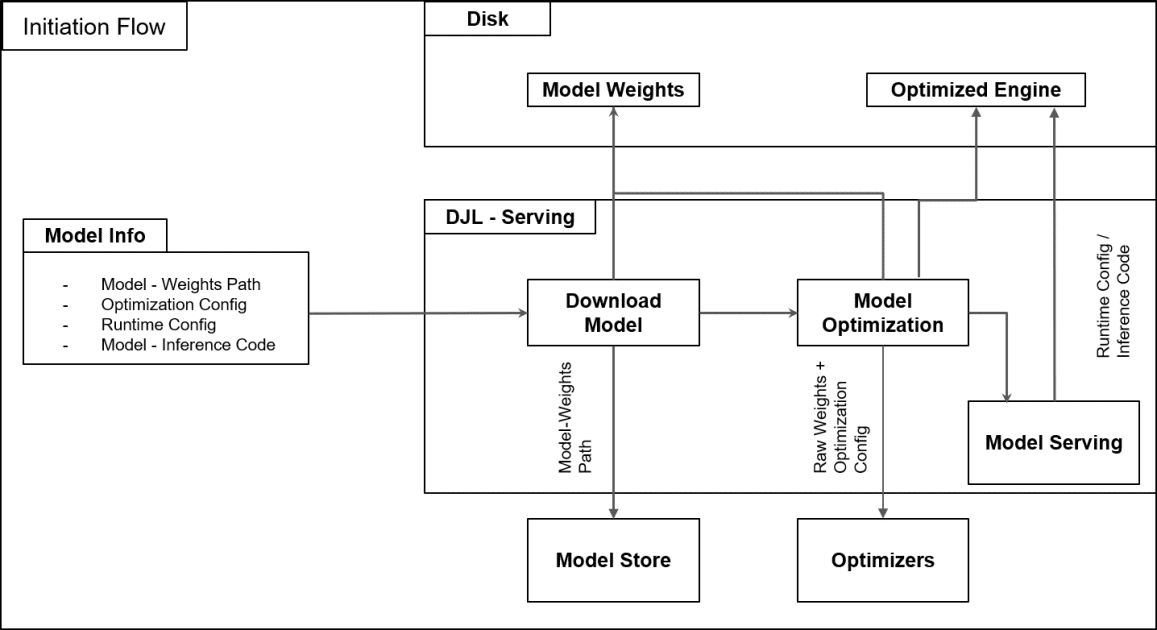

Para abordar estos retos, el equipo ha creado un marco de alojamiento en AWS diseñado para simplificar la gestión del ciclo de vida de los modelos. Utilizan Amazon SageMaker AI, que proporciona herramientas para soportar inferencias distribuidas y despliegues de múltiples modelos, ayudando a evitar cuellos de botella de memoria y a reducir los costos relacionados con el hardware. SageMaker también facilita la utilización de contenedores de aprendizaje profundo que aceleran el desarrollo e implementación, permitiendo a los ingenieros centrarse en la optimización de modelos en lugar de perder tiempo en configuraciones de infraestructura.

Adicionalmente, Salesforce ha adoptado una serie de prácticas recomendadas para el despliegue en SageMaker AI, permitiendo el uso óptimo de GPU y una mejor asignación de memoria. Esto se traduce en un despliegue rápido y eficiente de modelos optimizados, cumpliendo con las exigencias de alta disponibilidad y baja latencia.

A través de un enfoque modular en el desarrollo, Salesforce garantiza que las mejoras en un proyecto no interfieran con otros. Actualmente, están explorando diversas técnicas de optimización e investigando nuevas tecnologías para mejorar aún más la eficiencia en costos y energía. Las colaboraciones continuas con la comunidad de código abierto y proveedores en la nube como AWS aseguran la incorporación de las últimas innovaciones en sus procesos.

En el ámbito de la seguridad, Salesforce ha establecido estándares rigurosos desde el inicio del ciclo de desarrollo, implementando mecanismos de encriptación y controles de acceso para proteger los datos. Las pruebas automatizadas aseguran que la velocidad de implementación no traduzca en compromisos de seguridad.

Conforme las necesidades de IA generativa de Salesforce siguen en aumento, el equipo permanece comprometido con la mejora continua de su infraestructura de despliegue, explorando nuevas metodologías y tecnologías para mantenerse a la vanguardia en esta apasionante área de la inteligencia artificial.