Compartir:

Las empresas aeroespaciales enfrentan hoy un desafío generacional en su fuerza laboral. Con la fuerte recuperación post-COVID, los fabricantes están comprometidos con tasas de producción récord, lo que requiere compartir conocimientos especializados con más trabajadores. Al mismo tiempo, mantener el número de empleados y el nivel de experiencia es cada vez más difícil debido a la jubilación de una generación de expertos y a la creciente fluidez del mercado laboral post-COVID. Este conocimiento se captura tradicionalmente en manuales de referencia, boletines de servicio, sistemas de boletines de calidad, dibujos de ingeniería y más. Sin embargo, la cantidad y complejidad de los documentos está aumentando y requiere tiempo para aprender. No se puede entrenar nuevos expertos de la noche a la mañana. Sin un mecanismo para gestionar esta brecha en la transferencia de conocimientos, la productividad en todas las fases del ciclo de vida podría verse afectada al perder conocimientos expertos y repetir errores pasados.

La inteligencia artificial generativa (IA generativa) es una forma moderna de aprendizaje automático que ha mostrado avances significativos en razonamiento, comprensión de contenidos e interacción humana. Puede ser un multiplicador de fuerza significativo para ayudar a la fuerza laboral humana a digerir, resumir y contestar rápidamente preguntas complejas de grandes bibliotecas de documentos técnicos, acelerando el desarrollo de la fuerza laboral. AWS se encuentra en una posición única para ayudar a enfrentar estos desafíos a través de la IA generativa, con una amplia y profunda gama de servicios de IA/ML y más de 20 años de experiencia en el desarrollo de tecnologías IA/ML.

Este artículo muestra cómo los clientes aeroespaciales pueden utilizar los servicios de IA generativa y basados en ML de AWS para abordar este uso de conocimientos basados en documentos. Mediante un chatbot de preguntas y respuestas (Q&A) se proporciona orientación experta al personal técnico basándose en grandes bibliotecas de documentos técnicos. Nos centramos en el uso de dos servicios de AWS:

– Amazon Q puede ayudarte a obtener respuestas rápidas y relevantes a preguntas urgentes, resolver problemas, generar contenido y tomar acciones utilizando los datos y la experiencia encontrada en los repositorios de información de tu empresa, código y sistemas empresariales.

– Amazon Bedrock es un servicio completamente administrado que ofrece una selección de modelos de base de alto rendimiento de empresas de IA líderes a través de una única API, junto con un amplio conjunto de capacidades para construir aplicaciones de IA generativa con seguridad, privacidad y IA responsable.

Aunque Amazon Q es una excelente manera de comenzar sin código para los usuarios empresariales, Amazon Bedrock Knowledge Bases ofrece más flexibilidad a nivel de API para desarrolladores de IA generativa; exploramos ambas soluciones en las siguientes secciones. Pero primero, revisemos algunos conceptos básicos sobre aplicaciones de Generación de Recuperación Aumentada (RAG).

Aunque la IA generativa tiene un gran potencial para automatizar tareas complejas, nuestros clientes en la industria aeroespacial a menudo expresan preocupaciones sobre el uso de la tecnología en un sector tan sensible a la seguridad. Plantean preguntas como: «¿Cómo mantengo seguras mis aplicaciones de IA generativa?», «¿Cómo me aseguro de que mis datos críticos no se utilicen para entrenar modelos propietarios?», «¿Cómo sé que las respuestas son precisas y sólo provienen de fuentes autorizadas?», “¿Cómo puedo rastrear el razonamiento de mi modelo hasta los documentos fuente para generar confianza en los usuarios?”, y “¿Cómo mantengo mis aplicaciones de IA generativa actualizadas con una base de conocimientos en constante evolución?”.

En muchas aplicaciones de IA generativa basadas en bibliotecas de documentos técnicos propietarios, estas preocupaciones pueden abordarse utilizando la arquitectura RAG. RAG ayuda a mantener la precisión de las respuestas, mantenerse al día con el ritmo rápido de actualizaciones de documentos y proporcionar razonamiento trazable manteniendo los datos propietarios privados y seguros.

Esta arquitectura combina un modelo de lenguaje grande de propósito general (LLM) con una base de datos de documentos específica del cliente, que se accede a través de un motor de búsqueda semántico. En lugar de ajustar finamente el LLM a la aplicación específica, la biblioteca de documentos se carga con el material de referencia relevante para esa aplicación. En RAG, estas fuentes de conocimiento a menudo se denominan base de conocimiento.

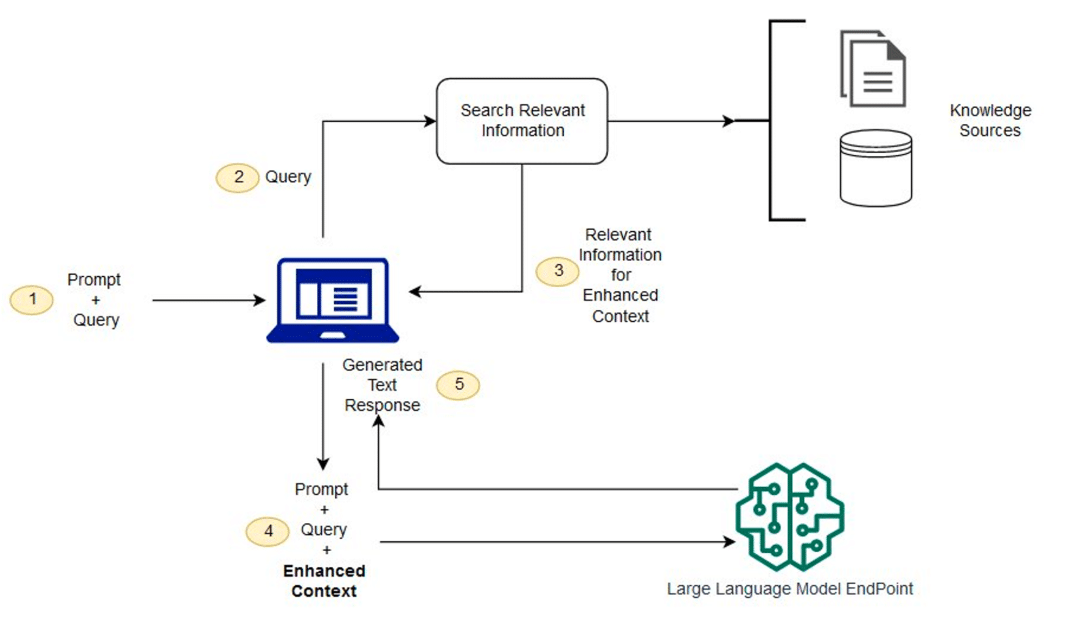

La arquitectura de RAG se muestra en la siguiente figura. El flujo de trabajo incluye los siguientes pasos:

1. Cuando el técnico tiene una pregunta, la ingresa en el chat.

2. La pregunta del técnico se usa para buscar en la base de conocimientos.

3. Los resultados de la búsqueda incluyen una lista clasificada de la documentación fuente más relevante.

4. Esos fragmentos de documentación se añaden a la consulta original como contexto y se envían al LLM como un prompt combinado.

5. El LLM devuelve la respuesta a la pregunta, sintetizada del material fuente en el prompt.

Debido a que RAG utiliza una búsqueda semántica, puede encontrar material más relevante en la base de datos que una simple coincidencia de palabras clave. Esta arquitectura aborda las preocupaciones mencionadas de varias maneras clave. El LLM subyacente no requiere entrenamiento personalizado porque el conocimiento especializado en el dominio está contenido en una base de conocimientos separada. Las respuestas de IA generativa pueden restringirse a fuentes de documentos confiables y proporcionar atribución directa a esos documentos fuentes para verificar. Los sistemas basados en RAG pueden gestionar de manera segura el acceso a diferentes bases de conocimientos mediante control de acceso basado en roles, manteniendo el conocimiento propietario privado y protegido.

AWS proporciona a los clientes en aéreo y otros dominios de alta tecnología las herramientas necesarias para construir rápidamente y desplegar de manera segura soluciones de IA generativa a gran escala, con seguridad de clase mundial. Veamos cómo puedes usar Amazon Q y Amazon Bedrock para construir soluciones basadas en RAG en dos casos de uso diferentes.

En el primer caso de uso, se crea un chatbot «experto» para técnicos con Amazon Q, una industria de alto contacto donde los técnicos están en la primera línea de la fuerza laboral. El trabajo de los técnicos aparece en cada etapa del ciclo de vida de la aeronave (y sus componentes), incluyendo el prototipo de ingeniería, pruebas de calificación, fabricación, inspección de calidad, mantenimiento y reparación. El trabajo técnico es exigente y altamente especializado, y requiere conocimiento detallado de documentación técnica para asegurar que los productos cumplan con los requisitos de seguridad, funcionales y de costos. La gestión del conocimiento es una alta prioridad para muchas empresas, buscando difundir el conocimiento del dominio de los expertos a los empleados más jóvenes para compensar la rotación, escalar la capacidad de producción y mejorar la calidad.

Nuestros clientes nos preguntan frecuentemente cómo pueden usar chatbots personalizados construidos en modelos de IA generativa personalizados para automatizar el acceso a esta información y ayudar a los técnicos a tomar decisiones mejor informadas y acelerar su desarrollo. La arquitectura RAG mostrada en este artículo es una excelente solución para este caso de uso porque permite a las empresas desplegar rápidamente chatbots de IA generativa especializados en dominios construidos de manera segura en su propia documentación propietaria. Amazon Q puede desplegar sistemas RAG totalmente gestionados y escalables, adaptados para abordar una amplia gama de problemas empresariales, proporcionando información y asesoramiento inmediato y relevante para ayudar a agilizar tareas, acelerar la toma de decisiones y fomentar la creatividad e innovación en el trabajo. Puede conectarse automáticamente a más de 40 fuentes de datos diferentes, incluyendo Amazon S3, Microsoft SharePoint, Salesforce, Atlassian Confluence, Slack y Jira Cloud.

En el segundo caso de uso, se aborda Amazon Bedrock Knowledge Bases como una opción para los desarrolladores de IA generativa que necesitan más control granular de parámetros relacionados con la base de datos vectorial, fragmentación, recuperación y modelos utilizados para generar respuestas finales. AWS ofrece una gama de servicios de IA/ML para ayudar a desarrollar soluciones de IA generativa para estos casos y más, incluyendo servicios recientemente anunciados como Amazon Q y Amazon Bedrock, que proporcionan acceso rápido a nivel de API a una amplia gama de LLMs, con gestión de bases de conocimiento para tus bibliotecas de documentos propietarios y integración directa a flujos de trabajo externos a través de agentes.

AWS también ofrece competitividad en precio-rendimiento para cargas de trabajo de IA, ejecutándose en hardware especializado como AWS Trainium y AWS Inferentia, procesadores diseñados para ejecutar tus servicios de IA generativa de la manera más rentable, escalable y fácil de gestionar. Enfrenta hoy tus desafíos empresariales más difíciles con IA generativa en AWS.