Compartir:

En un mundo donde las aplicaciones de inteligencia artificial y aprendizaje automático están en constante evolución, la optimización del rendimiento y la reducción de costos se han vuelto cruciales para las soluciones tecnológicas. Este reto se observa en diversos campos, como el procesamiento de datos en sistemas financieros, los motores de recomendación que examinan la actividad de los usuarios y los modelos de visión por computadora que procesan imágenes de video.

En este contexto, el monitoreo personalizado de modelos para inferencias por lotes casi en tiempo real con Amazon SageMaker se ha convertido en una herramienta esencial. No solo asegura que la calidad de las predicciones sea vigilada continuamente, sino que también permite detectar cualquier desviación de manera oportuna.

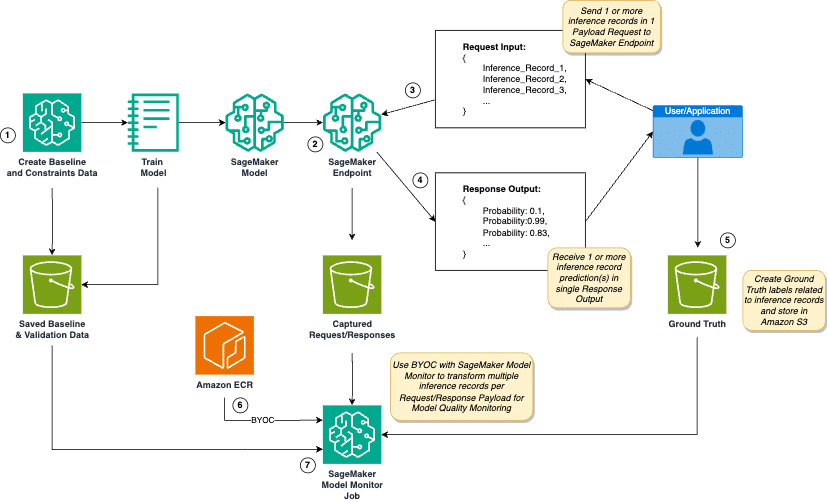

Para enfrentar estas necesidades, se ha desarrollado un marco que permite personalizar el uso de Amazon SageMaker Model Monitor. Este sistema maneja solicitudes de inferencia de múltiples cargas útiles en entornos de inferencia casi en tiempo real. SageMaker Model Monitor supervisa la calidad de los modelos de aprendizaje automático en producción, para detectar proactivamente cualquier desviación en su calidad.

La implementación de este tipo de soluciones personalizadas ofrece a los desarrolladores de AI/ML la capacidad de reducir el número de invocaciones al agrupar múltiples registros de inferencia en una sola solicitud. Sin embargo, para satisfacer requisitos comerciales específicos, se recomienda un enfoque de «Bring Your Own Container» (BYOC) con SageMaker Model Monitor.

Aunque el uso de contenedores personalizados puede parecer complejo, con el marco adecuado se puede acelerar el desarrollo de SageMaker Model Monitor BYOC para cumplir con las exigencias de monitoreo particulares. Este marco no solo facilita el manejo de solicitudes con múltiples cargas útiles, sino que también permite el uso de datos de referencia y la generación de métricas de calidad del modelo personalizadas.

El monitoreo de la calidad del modelo se lleva a cabo mediante un flujo de trabajo sistemático que incluye desde la creación de datos básicos y de validación antes y después del entrenamiento de un modelo, hasta la configuración de un endpoint de SageMaker con scripts de inferencia personalizados, y la generación de métricas comparativas entre los datos de captura en tiempo real y los datos de referencia.

En conjunto, este enfoque dota a las empresas de las herramientas necesarias para mantener la calidad de sus modelos de inteligencia artificial, adaptándose a las condiciones cambiantes del mundo real y garantizando que cualquier desviación en los resultados sea identificada y corregida de manera eficiente.