Compartir:

Investigadores de Microsoft han desarrollado SpreadsheetLLM, un método innovador para mejorar el rendimiento de los grandes modelos de lenguaje (LLMs) en la comprensión y procesamiento de hojas de cálculo, un desafío significativo debido a la estructura bidimensional y la diversidad de formatos de estos documentos.

Desafíos y Soluciones

Las hojas de cálculo, ampliamente utilizadas en plataformas como Microsoft Excel y Google Sheets, presentan complejos desafíos para los LLMs debido a sus extensas cuadrículas y variadas opciones de formato. Para abordar esto, el equipo de Microsoft introdujo SpreadsheetLLM, un método de codificación eficiente diseñado para optimizar la capacidad de comprensión y razonamiento de los LLMs.

Inicialmente, los investigadores propusieron un enfoque de serialización sencillo que incluía direcciones de celdas, valores y formatos. Sin embargo, este método resultó limitado por las restricciones de tokens de los LLMs, lo que lo hizo impráctico para muchas aplicaciones.

Innovación con SheetCompressor

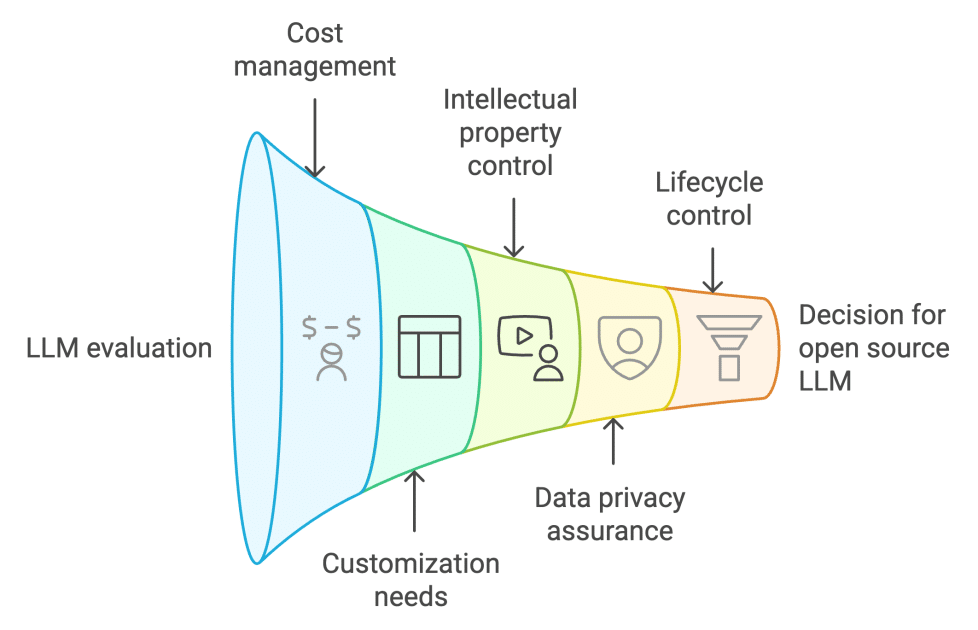

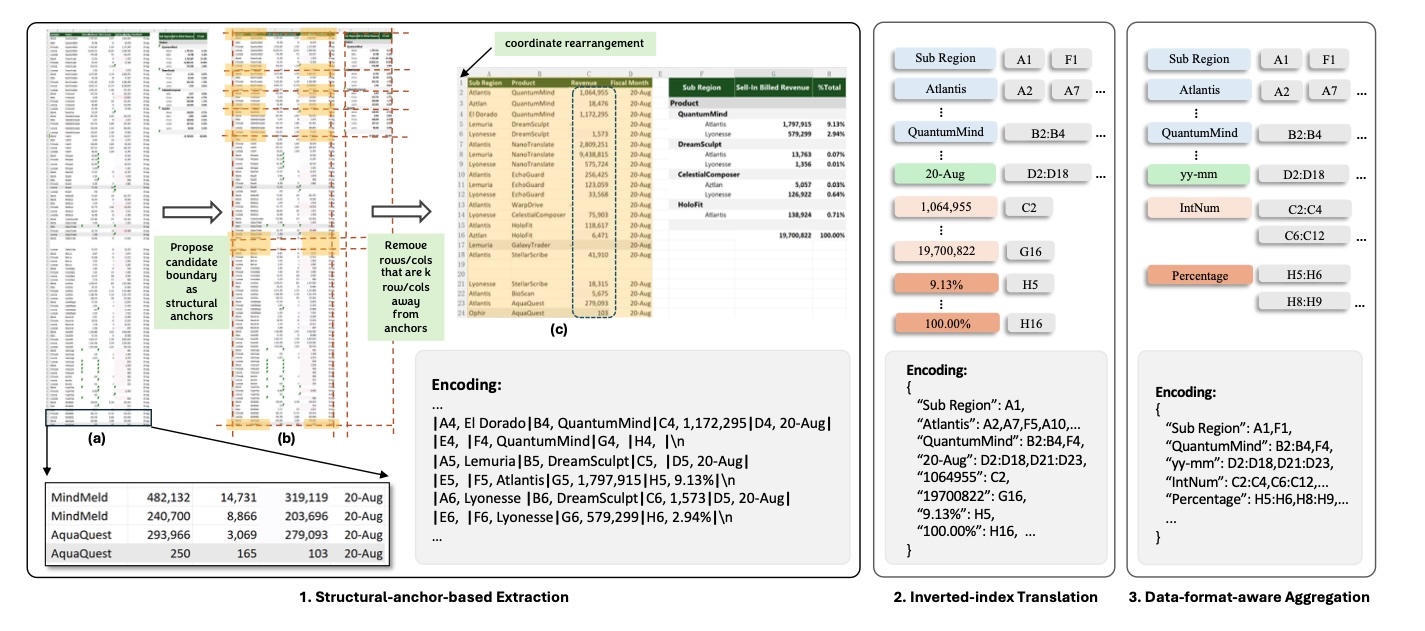

Para superar estas limitaciones, se desarrolló SheetCompressor, un marco de codificación innovador que comprime las hojas de cálculo de manera efectiva. Este sistema incluye tres módulos:

- Compresión basada en anclas estructurales: Identifica filas y columnas heterogéneas que ofrecen información sustancial sobre la estructura del documento, eliminando filas y columnas homogéneas y distantes.

- Traducción de índice invertido: Emplea una traducción en formato JSON que optimiza el uso de tokens al indexar textos de celdas no vacías y combinar direcciones con textos idénticos.

- Agregación consciente del formato de datos: Agrupa celdas adyacentes con formatos o tipos de datos similares, mejorando la comprensión de la distribución de datos numéricos sin gastar excesivos tokens.

Resultados y Rendimiento

La implementación de SheetCompressor ha mostrado una mejora significativa en la detección de tablas en hojas de cálculo, superando el enfoque inicial en un 25.6% en configuraciones de aprendizaje contextual de GPT-4. Además, un LLM ajustado con SheetCompressor logró un ratio de compresión promedio de 25 veces, obteniendo una puntuación F1 de 78.9%, lo que supera en un 12.3% a los mejores modelos existentes.

Aplicaciones y Futuro

El estudio también presentó Chain of Spreadsheet (CoS), una metodología para tareas descendentes de comprensión de hojas de cálculo, validada en una nueva y exigente tarea de preguntas y respuestas (QA) en hojas de cálculo. Esta metodología demostró ser altamente efectiva en una variedad de tareas, optimizando el procesamiento y mejorando la interacción inteligente del usuario con datos de hojas de cálculo.

La introducción de SpreadsheetLLM y SheetCompressor representa un avance significativo en la capacidad de los LLMs para manejar y comprender datos de hojas de cálculo complejos, abriendo nuevas posibilidades para aplicaciones avanzadas de análisis de datos y asistencia automatizada.

Conclusión

SpreadsheetLLM y su componente SheetCompressor marcan un hito en la evolución de los modelos de lenguaje para la comprensión de hojas de cálculo, ofreciendo una solución eficiente y robusta para los desafíos de tokenización y estructura que tradicionalmente han limitado el rendimiento de estos modelos en este dominio.

Para más información, consulte el documento completo del estudio aquí(2407.09025v1).